AIワークステーション DeepLearningBOXⅢ

カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

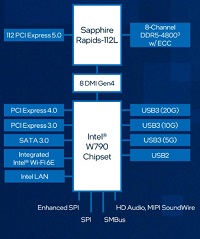

- Intel Xeon

- 1CPU

- 3GPU

- PCIe 5.0

- 10GbE

- IPMI

- SATA

- M.2

- slim SAS

- NVMe

- 8 DIMM slots

- DDR5

- ECC Registered

- 1年保証

- 3年保証

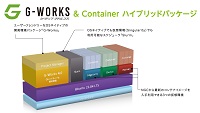

G-Suiteは、これまでジーデップ・アドバンスが提供してきた「G-Works」の仕組み(Deep Learning の主要なフレームワークを、各世代のGPU に最適化してビルドしたソフトウェア群)を継承し、さらに発展させたOS ネイティブ環境+コンテナ環境のハイブリッドアプリケーションリソースマネージメントツールです。インターネット上のWeb サイトから様々なレシピやサポートツール群をダウンロードし、簡易解説書やチュートリアルを含むアプリケーション実行環境を構築することが可能です。Ubuntu 24.04に対応し、開発環境は miniforgeをベースとしています。各世代のGPU に最適化してビルドしたソフトウェア群に加え、OS ネイティブ環境+コンテナ環境をハイブリッドにサポートしています。

Ubuntu 22.04に対応する「G-Works4.0」を選択されたい場合はこちらからご覧ください。