GDEP フルスタック GDEP Fullstack

大規模AI計算に最適なフルスタックシステム

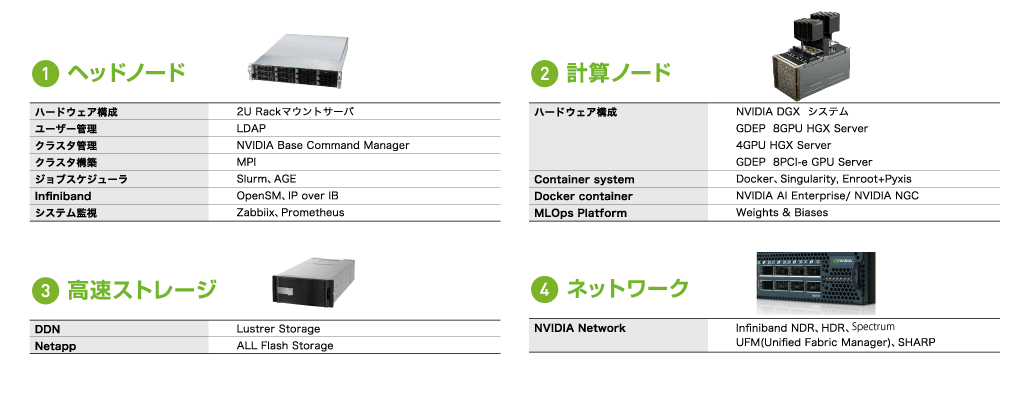

最適なヘッドノード+計算ノード+ストレージシステム+高速ネットワーク構成をご提供

大規模言語学習(LLM)での利用活用においては、大量のテキストデータ用いて数十億ものパラメータから成る巨大なニューラルネットワークの構築の必要性が求められます。ジーデップ・フルスタックは、高性能な複数GPUノード、高速ストレージを高帯域で接続するリファレンスシステムです。

システムの特徴

計算パフォーマンスを最大限に発揮

計算パフォーマンスを最大限に発揮NVIDIAリファレンスシステムで構成された複数の最新マルチGPU計算ノードをNVIDIA高速ネットワークで接続、計算リソースを集約し、GPUに最適化された最新のソフトウェアをDockerコンテナにて展開することで、環境構築も容易です。構築からすぐに研究開発が行え、ジョブスケジューラの管理の下で、計算リソースを最大限に活用することができます。

優れた管理ツールにより、安全かつ安定したシステム運用を実現

優れた管理ツールにより、安全かつ安定したシステム運用を実現ディレクトリサービスを用いて、ユーザー、ファイル、デバイスなど様々なネットワーク内の情報を一元管理することにより、安全な環境を実現。システム監視を常時行うことにより、異常の検知もすぐに行うことができ、システムダウン回避や原因究明に必要なさまざまな情報収集が可能。ダウンタイムの短縮に役立ちます。計算ノードの交換が必要になった場合でも、プロビジョニング機能を用いて、すぐに環境構築が可能になります。

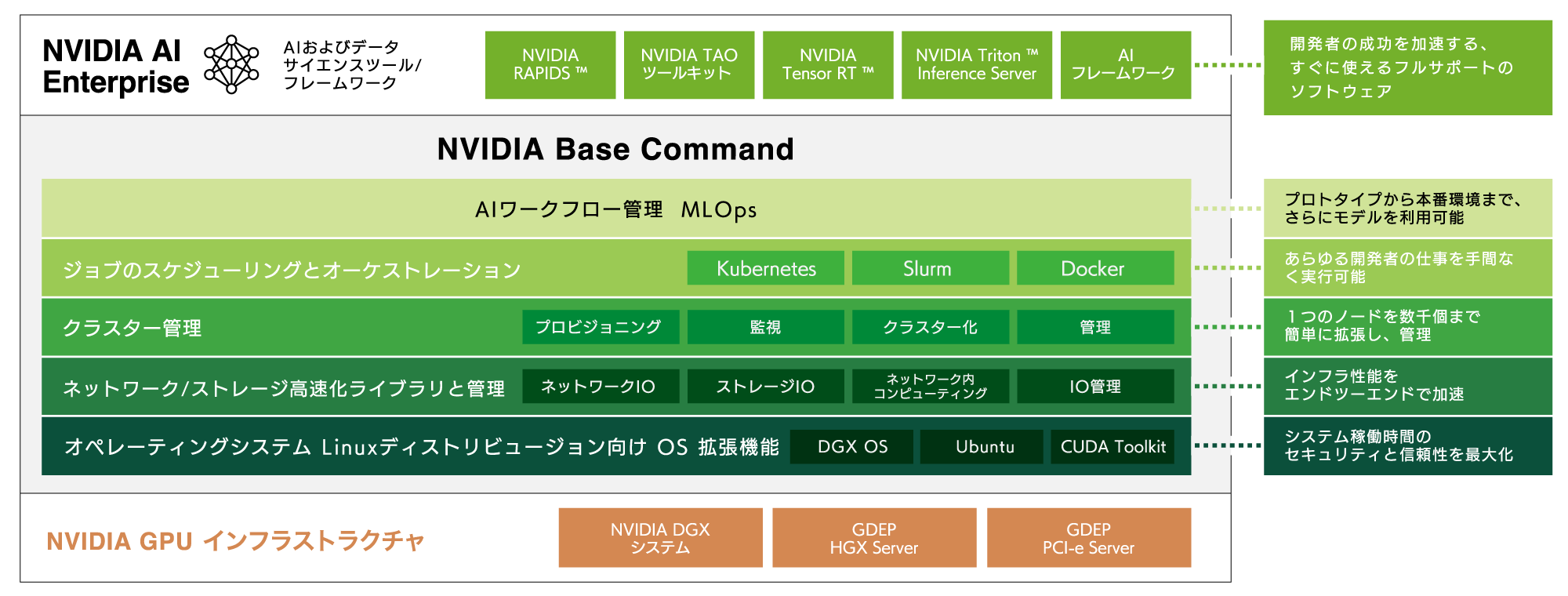

NVIDIA AI開発ツールで環境構築

NVIDIA AI開発ツールで環境構築NVIDIA NGC + NVIDIA AI Enterprise

NVIDIA社が提供する「NVIDIA NGC」は、ソフトウェア、管理ツール、サポートでAIとデジタルツインのエンドツーエンドワークフローを支援するポータルであり、幅広い業種に対応したプラットフォームを提供します。

さらにNVIDIA AI Enterpriseを用いて、一元管理されたプラットフォームで学習・推論・データ分析などのAIワークロードを迅速に展開、管理を行うことが可能です。

ユーザーの計算リソース最適配分

ユーザーの計算リソース最適配分Docker 仮想環境対応

ジョブスケジューラツールによる計算リソース最適配分を行うことが可能です。複数のプロジェクトで大小の計算ジョブが発生するケースでも、計算リソースを最適に配分することにより、コンピュートリソースを最大限に活用することで、ROI を向上、より良い結果を迅速に提供することができます。Docker環境にも対応しているため、環境構築からジョブの実行までシステム運用の負担を軽減することができます。

推奨アプリーケーション

システム設計・提案

大規模なAIを効率よく学習するためのノードサイズやネットワーク構成をお客様のご要望を伺いながらご予算に合わせて設計していきます。NVIDIA社DGXシリーズではグローバルで実績のあるリファレンス構成でも提供が可能です。ジーデップ・アドバンスではグローバルなサーバーベンダー、ストレージベンダー、ソフトウェアベンダー、国内SIer、コンサル各社と協力なエコシステムを構築しており、お客様のご予算に合わせた最適なAIシステムをフレキシブルに提案致します。

導入・設置

創業以来国内最多のDGXシステムをお客様のサーバールームや契約データセンターへ納入しているジーデップ・アドバンスだからこそ、スピーディで安全な導入・設置作業が可能です。お客様の電源環境や排熱設備なども考慮し、最適なご提案と確実な作業を行います。

また、国内のデータセンター数社と提携しており、例えば水冷対応のラックや30KVA以上の高負荷対応の電顕環境など、最新の高電力高排熱の計算ノードを安定稼働できるファシリティをご用意できます。

運用支援・プライベートクラウド

NVIDIA Base Command™ ManagerなどAIプラットフォーム全体の統制と管理を行える最適化ツールの運用支援はジーデップ・アドバンスが最も得意とするところです。大規模なGPUクラスタシステム、AIシステムを理想的な形で運用開始するできるまでしっかりとお手伝いさせて頂きます。

また、お客様のファシリティ環境にてシステム導入が困難な場合、データーセンターのハウジングサービスをセットにしたプライベートクラウドの形態でご提供させていただきます。ハードウエアに関する運用を全てを弊社にて対応しますので、お客様はシステムメンテナンスから解放され本来の開発業務に専念することが可能です。